Introduction :

Cet article a un double but. Le premier est de répondre aux critiques de Hugo Lagouge (dit @Tranxen1 sur X) par rapport à ma conférence du 22 avril 2023 aux Rencontres de l’Esprit Critique à Toulouse, et le deuxième, pour moi bien plus intéressant puisqu’il va au-delà du cas particulier, touchant au domaine de la philosophie des sciences, sera de faire l’analyse de ce cas pour illustrer une méthode que je vais nommer la « méthode idéologique », similaire à toute forme d’idéologie marquée qui s’invite dans le domaine scientifique. Cette partie de l’analyse ne portera plus seulement sur Tranxen (ou alors comme illustration de certains points), mais sur la communauté ZEM et Sympathisant·es (ZEM&S), et encore plus généralement ce qu’on peut appeler les excès de l’extrême-gauche (nommés « wokisme » par ses détracteurs). Tranxen me demande à l’avance à plusieurs reprises d’éviter les « hommes de paille », ne pas lui faire dire ce qu’il ne dit pas, et ne pas l’amalgamer à des propos que d’autres ont tenu. Je vais bien entendu mentionner de qui je parle lorsque je critique tel ou tel affirmation ou argument, mais Tranxen ne pourra pas m’empêcher de faire un rapprochement entre ses arguments et ceux que d’autres avancent, quand il me semble que le rapprochement peut être fait.

Avertissement préliminaire de philosophie basique du langage : Dès qu’on utilise un terme désignant une collectivité, on commet des erreurs. Dès que l’on parle des Suisses, des Français, des hommes et des femmes, des gauchistes, des libéraux, « wokistes », « extrême-droite », extrême-gauche, centre, etc., etc., on parle après Wittgenstein et son exemple célèbre des ressemblances de familles concernant la catégorie des jeux, de catégories floues. Il y a des Franco-suisses qu’on peut classer dans les deux groupes, des clandestins qu’on ne sait pas trop où classer, des catégories de genre nouvelles, etc. Encore pire dans le domaine des attitudes, les gens qui composent un collectif ne partagent pas toutes et tous les mêmes avis, mais on note néanmoins une tendance à accepter le même genre de propositions (sinon on ne pourrait pas les classer, ou eux se classer dans le collectif). Ainsi, quand Tranxen parle de la « la zététique à l’ancienne », des « centristes », il commet la même approximation que quand on parle des « ZEM&S », ou de l’« extrême-gauche » ou de l’« extrême-droite ». Il est inévitable, ce n’est pas un amalgame ni un homme/femme de paille (épouvantail), que de critiquer comme un ensemble des positions politiques ou idéologiques que l’on considère voisines, même si chaque individu du collectif pourra bien sûr varier sur l’intensité de ces positions. Tranxen a écrit lui-même « je me sens proche du collectif Zet-éthique Meta-critique par exemple », ce qui fait que je le classe parmi les ZEM&S, mais dans la suite de ce texte, je séparerai ce qui vient de lui et d’autres ZEM&S. Il est heureux que tous les ZEM&S, ou encore plus les personnes d’extrême-gauche, ne partagent pas toutes et tous les mêmes opinions, pas plus que les « zététiciens à l’ancienne », ou les psychologues, ou les gens qui se définissent comme centristes. Tant mieux ou tant pis si certaines critiques que j’attribue aux ZEM&S, à l’extrême-gauche ne sont pas partagées par Tranxen, je les classe ensemble parce qu’elles participent selon moi — à tort ou à raison, chacun·e pourra en juger — de la même idéologie. Le véritable amalgame est exemplifié par le récent tweet d’un membre ZEM&S : « quand il y a deux fascistes sur une table de 145 personnes, il y a 145 fascistes autour de la table ».

Si donc Tranxen n’est pas d’accord avec mon analyse de sa critique comme exemple de cognition motivée de l’extrême-gauche (puisqu’il me demande poliment de ne pas l’analyser comme telle, par une forme de pensée magique), il pourra ne se focaliser que sur la liste des erreurs qu’il a commises dans sa critique — ce qui pourrait finalement lui être profitable — quand je le signale nommément, et il pourra ignorer le reste des points soulevés, qui sont pour moi tout aussi intéressants. Au-delà du règlement de comptes (qui pour moi est largement soldé, vous pourrez en juger si vous arrivez à la fin de ce long texte), j’en profiterai pour préciser certains aspects intéressants comme la conception de la rationalité en psychologie cognitive, la critique des sondages et/ou des recherches par questionnaire (qui doit se faire de manière scientifique et rationnelle, et pas idéologique), le risque d’irrationalité à l’extrême-gauche, etc.

La critique de Tranxen de ma conférence donnée aux REC souffre en effet de nombreux problèmes. Elle est mal informée, arrogante à la limite de la diffamation sur X (il me compare à Raoult et dit de ma conférence qu’elle est « crée un précédent dangereux » et qu’elle induirait le public en erreur en propageant « une vision à côté de la plaque de l’état du débat scientifique », et « s’apparente à de la désinformation scientifique », elle « fait dire à la littérature scientifique l’inverse de ce qu’elle dit réellement, ou au mieux [de] brasser de l’air avec » ; si Tranxen avait une large audience, je songerais à porter plainte ; je ne vais évidemment pas le faire, d’autant moins que celles et ceux qui échangent avec les ZEM&S connaissent leur ton souvent trop sûr de soi et quérulent, ce qui est d’ailleurs l’un des éléments de la présente analyse), et commet comme on le verra un grand nombre d’erreurs. Il est possible que ces erreurs soient en partie aussi dues à quelques imprécisions de ma part (toute conférence et tout propos oral, même parfois écrit, peut être ambigu ou parfois exagéré sans qu’on y prenne garde, surtout dans le domaine de la vulgarisation), mais nous verrons quel est le bilan final en termes d’erreurs des deux côtés. Nous verrons aussi que la critique de Tranxen a des points communs évidents avec ce que j’appelle ici la « méthode idéologique », typique de l’intrusion de l’idéologie dans la science :

(1) Tranxen veut montrer que les arguments que je présente dans ma conférence sont soit faux, soit relèvent d’un point de vue minoritaire dans le champ de la psychologie (dans lequel il ne travaille pas), tout simplement parce que mes arguments vont à l’encontre son idéologie. Dans sa réponse, il me demande :

« Et si la pensée critique vous intéresse, j’espère que vous ne vous arrêterez pas à une idée comme « Tranxen n’a pas aimé la conférence parce que ça va à l’encontre de son idéologie ! », parce que vous verrez que ce n’est pas le propos ».

Mais je ne vais pas « m’arrêter » à cette idée, je ne vais pas partir l’a priori que c’est vrai (ce qui serait exactement la méthode de Tranxen et autres idéologues ZEM&S et plus largement d’extrême-gauche que je dénonce). Je vais faire ce que je propose pour toute forme de connaissance, regarder ce que disent les « données » (avec mon interprétation), analyser la réponse de Tranxen et voir si cette réponse traduit un réel désir d’améliorer les résultats que j’ai présentés, de voir en quoi j’avais raison sur certains points et tort sur certains autres. Or, devinez quoi ? Il n’y a AUCUN élément dans ma conférence qui trouve grâce à ses yeux, sauf le seul « point positif : les données brutes sont accessibles » de l’une de nos études, pour montrer que j’ai en fait tort. Cela veut dire qu’il n’y a selon lui RIEN à conserver de mes 30 ans de connaissances scientifiques sur le sujet ! Alors je veux bien admettre que je suis loin d’être un génie (contrairement à d’autres qui se ridiculisent à le croire et le clamer bien haut), mais si en 30 ans de profession je n’en ai pas appris plus que Tranxen qui aborde les mêmes questions en amateur, cela vaut effectivement la comparaison avec Raoult (voire plutôt Montagnier) ! Dans une conversation sur Mastodon qu’on m’a rapportée, Tranxen transmet son blog à Marie Peltier, qui le remercie, et il commente : « les contenus comme ça qui jettent le discrédit et pourrissent les débats ça a tendance à m’énerver ». Je vais donc évaluer son propre contenu.

Si vraiment « ce n’était pas le propos », si la motivation de Tranxen était la recherche scientifique de vérité — ou du moins de ce qui est actuellement le moins vraisemblablement faux —, non seulement il ferait également une liste des éléments qu’il trouve corrects dans mon exposé (à moins qu’il n’y en ait effectivement pas, nous allons faire une revue de la littérature pour évaluer ce point), mais il publierait une liste de nombreux travaux qui complètent, voire infirment ceux que je présente, en démontrant qu’il n’y a pas plus d’irrationalité et de dogmatisme à l’extrême gauche qu’au centre (voire moins), et il produirait de même une longue liste de travaux qui montreraient que les biais cognitifs ne sont pas liés aux croyances. Au lieu de cela, il cite sur X à propos de ce 2ème point un texte : « Dedans, vous y verrez même des citations de H. Mercier qui contredisent textuellement des idées qui sont propagés par PWE », avec à l’appui une affirmation d’un chercheur du domaine, Hugo Mercier qui affirme que « le lien supposé entre une pensée analytique et l’adhésion à des croyances douteuses n’a rien de systématique ». Quand je lui réponds « je vous ferai la liste des travaux qui montrent un lien entre pensée analytique/intuitive et croyances douteuses », sentant sans doute à l’avance le vent du boulet, il rétropédale rapidement : « Moi, l’idée qu’il y a des liens entre la compétence de la pensée analytique et telle ou telle croyance, je suis plutôt d’accord, mais ma critique ne porte pas sur ça » (sa critique ne porte pas sur ça, mais il signale quand même des citations qui contredisent les idées que je propage : on ne comprend plus très bien ce qui fait partie de sa critique et ce qui n’en fait pas partie, ou plutôt on commence à très bien sentir la fragilité de sa critique pourtant vaillamment exprimée, avec ce rapide rétropédalage#1).

Ce qu’a fait Tranxen, au lieu donc d’une méthode critique constructive, éthique et respectueuse d’autrui qui consisterait à présenter les accords et désaccords basés sur un plus grand nombre d’études qui appuient son point de vue et que je n’aurais pas citées dans ma conférence, est une focalisation sur les détails des recherches que je présente pour tenter d’y trouver, en non-spécialiste, des erreurs, des détails sans importance, des mauvaises interprétations qui selon lui invalideraient le tout (on verra ci-dessous que c’est loin d’être le cas, c’est même le contraire). Et à la fin, en guise de bouquet final, sur X, il va de cette critique on le verra a posteriori assez minable (elle pourrait a priori être valable), va essayer d’insinuer que je suis un Raoult de la psychologie et que ma conférence s’apparente à de la désinformation.

C’est la caractéristique de la méthode idéologique des complotistes par exemple, qui au lieu d’enquêter et de tenter de valider la théorie du complot par une enquête professionnelle (fardeau de la preuve), vont (2) sélectionner une partie des études et données qui en apparence donnent du crédit à leur thèse et (3) tenter de trouver des failles dans la version officielle, des anomalies apparentes. Et on pourra toujours trouver de telles anomalies, qui ne sont pas forcément des indices que la version officielle est fausse (il y a quantité d’explications alternatives), et encore moins des preuves. Et leurs (mauvaises) conclusions sont ensuite postées avec force indignation en ligne, afin d’hystériser le débat. De la même manière, les militant·es antivaccins ne vont pas tenter (1) une synthèse des coûts/bénéfices des vaccins qui serait la stratégie rationnelle et scientifique, mais vont (2) sélectionner uniquement les études qui vont dans leur sens (p.ex. Jost pour Tranxen) et (3) critiquer les détails des études qui concluent à des effets positifs de la vaccination (l’analyse du W de la courbe d’une seule étude, sans citer ni sans doute connaître toutes les autres). Et à la fin, essayer de torpiller la réputation des spécialistes en suggérant qu’ils sont incompétents (ou corrompus si la première stratégie échoue), alors que c’est leur critique qui l’est.

On peut ajouter à la méthode idéologique, quelques jours plus tard au vu des réactions en ligne à mon texte, (4) l’inversion accusatoire et victimaire : Tranxen se plaint d’avoir le coeur vidé, sans doute suite à ma réponse à ses critiques virulentes, et d’autres le soutiennent, en oubliant bien sûr le même effet qu’il a délibérément causé en premier en me traitant de désinformateur et pire (Raoult), et en oubliant que sa critique aurait pu rester publiquement bien plus polie et constructive (comme elle l’a été en privé). Toutes les critiques ad personam (ignorance, arrogance, etc.) que je lui ai faites sont des réponses aux siennes, elles n’auraient jamais eu lieu sans ses propres attaques outrancières. Il faut rappeler que dans ma conférence aux REC, je mentionne juste les ZEM comme exemple pour moi d’intrusion de l’idéologie en zététique, sans aucune mention de personne ni attaque personnelle. Cette sorte de manque de métacognition sur ses propres actes s’intègre bien avec le manque de métacognition sur ses connaissances et lacunes du demi-expert (Dunning-Kruger). Il est normal de ne pas être conscient·e de ses limites, mais le fait de manquer totalement de prudence quant à ses connaissances face à des professionnels du domaine est le signe d’une forme de narcissisme très visible dans la critique idéologique.

La méthode idéologique (points 1-3) a été également décrite par Shermer (1997) à propos des créationnistes et des révisionnistes. Au lieu de produire comme en sciences une nouvelle théorie qui explique ce qu’explique l’ancienne théorie plus un nouveau contenu en partie corroboré (Lakatos), ce qui infirmerait vraiment l’ancienne théorie, ils vont se concentrer sur certains détails, erreurs, anomalies apparentes de la théorie pour penser en déduire qu’elle est fausse. Mais comme le soulignait Lakatos, toute théorie est entourée d’un « océan d’anomalies » (sinon elle expliquerait tout), ce qui contrairement au point de vue strictement poppérien, ne la réfute pas. Les créationnistes vont tenter de trouver tel ou tel cycle de reproduction tellement complexe pour tenter de montrer que l’évolution par hasard n’est pas possible (comme par exemple le cycle de la douve du foie, l’apparition de l’œil, etc.), trouver quelques cas que la théorie de l’évolution a du mal à expliquer (sans doute temporairement, on découvrira aussi dans le futur d’autres mécanismes à l’œuvre, donc ce n’est évidemment en rien une réfutation de toute la théorie), focaliser sur l’absence de preuve expérimentale de l’apparition de la vie pour argumenter que c’est impossible (alors que l’absence de preuve n’est pas preuve de l’absence), et en oubliant sciemment les milliers de phénomènes qu’explique parfaitement la théorie de l’évolution. Les révisionnistes vont aussi se concentrer sur les apparentes anomalies (erreurs inévitables dans les témoignages, les documents, etc.) pour tenter de faire croire que l’ensemble de l’holocauste n’a pas eu lieu.

L’exemple le plus extrême de la méthode idéologique que je connaisse est celui du harcèlement que le psychologue Stephan Lewandowsky a subi dans les années 2010-2018, qu’il a décrit dans un chapitre éloquent (2019). Pendant ces années, il a été harcelé par les climatosceptiques par rapport à ses recherches sur la théorie du complot qui veut que le réchauffement climatique soit une invention de la gauche. Des demi-spécialistes ont réanalysé les données de certaines études afin de tenter de montrer que les résultats étaient incorrects (sans avoir les moyens de le faire), et des interprétations complotistes de l’article lui-même sont apparues sur le net (qu’il était payé par le gouvernement). Les complotistes ont même réussi à faire rétracter un article pour de mauvaises raisons (il a été republié dans une autre revue), et ils ont également écrit des plaintes à l’université contre le chercheur (et de nombreux téléphones, en un véritable harcèlement), lequel a également reçu des menaces personnelle, et des vidéos détournées sur Youtube. Lewandowsky décrit la violence des attaques, la toxicité des négationnistes de la science. Il a pu calculer qu’un seul individu a posté environ 400 tweets en 3 ans pour tenter de le diffamer lui ou son travail, soit environ un toutes les 66 heures (toute similarité avec d’autres personnes existant ou ayant existé sur les réseaux sociaux n’est que pure coïncidence)… Des phénomènes semblables ont pu être observé pendant la pandémie de la part des militant·es antivaccins.

Précisons que je ne prétends évidemment pas que les ZEM&S sont au niveau des créationnistes, des révisionnistes, ou pratiquent le harcèlement que subissent certains scientifiques par des militants antiscience, ce qui est plutôt le cas de certain·es militant·es anti-mesures sanitaires avec qui j’ai interagi. Mais pour moi les ZEM&S se situent au tout début de ce processus : défendre une idéologie donnée dès le départ peut à un niveau extrême mener à ces dérives.

A la défense de Tranxen, il est vrai que parfois — heureusement rarement parce que la plupart des spécialistes ne sont pas des escrocs ou des incompétents —, des non-spécialistes peuvent détecter des fraudes de la part de spécialistes, comme l’ont fait « Sonic Urticant » ou Alexander Samuel (ayant tous deux une formation scientifique mais ne publiant pas dans le domaine médical) lors de la pandémie avec certains articles de Didier Raoult. Donc il faudra effectivement se poser la question à la fin de ce texte si au vu des éléments présentés, nous sommes dans une configuration plutôt comme le prétend Tranxen (a) Wagner-Egger = Raoult (narcissique et incompétent) et Tranxen = lanceur d’alerte, ou plutôt comme je vais tenter de le démontrer (b) Wagner-Egger = expert (non pas infaillible mais ayant de bonnes connaissances du domaine) et Tranxen = antivax (incompétent, narcissique et quérulent), pour reprendre la rhétorique « provoc » de Tranxen sur X. Au vu des éléments rapportés ici, il me semble qu’il n’y a guère de doutes à avoir.

Développement

Cet article a donc un double but, le premier étant de répondre aux critiques de Hugo Lagouge (dit @Tranxen1 sur X) par rapport à ma conférence du 22 avril 2023 aux Rencontres de l’Esprit Critique à Toulouse :

Propos sur lesquels nous avons ensuite réalisé un entretien avec Mr. Sam pour dissiper certains malentendus et ajouter des éléments :

Le deuxième but bien plus intéressant de ce texte, touchant au domaine de la philosophie des sciences, sera de faire l’analyse d’une méthode que je vais nommer la « méthode idéologique », similaire à toute forme d’idéologie qui fait intrusion dans le domaine scientifique.

Précisons d’où nous parlons tous les deux : Hugo Lagouge se décrit sur son profil LinkedIn comme un curieux et passionné avec des expériences multidisciplinaires en sociologie, psychologie, sciences politique et économique, en théâtre, animation et en communication. Il dit aborder une multitude de sujets avec toujours une certaine exigence critique (parce qu’il sait que toutes les expertises ne se valent pas). Je n’ai trouvé aucune publication scientifique ou autre de sa part. Ses analyses se trouvent sur son blog et dans des vidéos en ligne.

Je suis depuis 1996 assistant-doctorant puis lecteur depuis 2004 au Département de Psychologie de Fribourg, dans lequel j’enseigne la psychologie sociale et les statistiques. J’ai publié une soixantaine d’articles et de chapitres dans des revues scientifiques, des ouvrages collectifs en français et en anglais, ainsi que quelques livres. J’ai passé ma thèse de doctorat en 2003 à l’Université de Lausanne, et ma thèse d’habilitation à l’Université de Fribourg en 2020. Ma thèse portait sur les facteurs sociaux dans le fonctionnement cognitif, ma thèse d’habilitation sur les croyances complotistes, et j’ai publié 7 articles scientifiques dans des revues à comité de lecture et un livre sur les biais cognitifs.

Il apparaîtra à certains que cette simple présentation a pour but de favoriser un argument d’autorité. En réalité, comme je le défends dans un de mes livres (Bellevaut & Wagner-Egger, 2022), l’argument d’autorité est parfaitement valable, statistiquement, lorsqu’un expert s’exprime dans son domaine de compétence : De façon probabiliste (sans certitude), l’avis d’un·e expert·e dans son domaine sera en moyenne meilleur que celui d’un·e demi-spécialiste (un·e amateur·trice qui aurait beaucoup lu sur le sujet mais ne publie pas), lequel sera en moyenne meilleur (ou parfois équivalent avec l’effet de surconfiance) avec l’avis d’un·e non-spécialiste, à moins de supposer que l’acquisition de connaissances et de l’expertise n’a aucun effet sur la connaissance. L’argument d’autorité devient effectivement un biais rhétorique quand l’expert·e s’exprime hors de son domaine de compétence, avec lequel il va tenter d’influencer autrui par le fait que son aura dans son domaine ferait de lui une source fiable dans d’autres domaines (ce qui est loin d’être le cas). Je ne souligne pas cela pour suggérer que j’aurais raison — sinon j’arrêterais là et m’épargnerais la longue démonstration qui suit —, mais plutôt pour souligner que Tranxen devrait à la base faire preuve de beaucoup plus de prudence, poser des questions au lieu d’affirmer par exemple, dans sa critique.

Comme le souligne Tranxen (au passage, son pseudo est une référence sympathique à un sketch des Inconnus), il y a effectivement mieux que l’avis d’un·e expert·e, c’est celui de plusieurs expert·es, ou mieux de la majorité des expert·es — ce qu’on appelle généralement consensus scientifique. Ainsi, il se peut que mon avis d’expert soit un avis minoritaire, c’est le principal argument de Tranxen, qui le conduit je pense à rien moins que me comparer à Raoult sur X. Ce sera l’une des questions cruciales de ce débat, parce que s’il a raison, mon point de vue est effectivement problématique puisqu’il conduit le public comme il le dit à avoir une image faussée de l’état des connaissances sur le sujet, mais s’il a tort, nous revoilà avec un exemple de critiques des « semi-intellectuels déclassés et frustrés » dont parle Boltanski (2012), pour désigner les complotistes qui ont un certain niveau d’éducation, ou les communistes d’antan qui n’avaient pas fait de hautes études, mais dont l’intelligence partielle était complètement mise au service de leur idéologie (ils étaient considérés comme les plus fanatiques des communistes).

Sur la forme

Il convient d’abord de s’arrêter sur la forme, parce qu’elle participe de cette « méthode idéologique » que je vais tenter d’illustrer dans ce texte. C’est (la forme) d’ailleurs l’un des éléments qui provoque des tensions dans le milieu de la zététique, et ce pour plusieurs raisons. (1) le collectif s’appelle « Zét-Éthique Méta-critique » (ZEM), ce qui indique déjà une posture de supériorité morale et épistémique auto-attribuée. Le mot éthique suggère que la zététique traditionnelle ne l’est pas assez, tout comme « critique ». Un membre ZEM&S reposté en avril 2024 par Tranxen, nous apprend qu’il a « fini de perdre tout espoir d’améliorer le mouvement sceptique de l’intérieur »…. Il sait donc ce qui est Bien et Bon ! Bon nombre de zététiciennes et zététiciens « traditionnels » se sont plaints de la virulence des attaques, à tel point que certain·es ont tenté de le quantifier en ligne : https://www.youtube.com/watch?v=t6V1TcYp51Q, et comme dans tout débat et encore plus sur les réseaux sociaux, cela a entraîné des contre-attaques, à tel point que les deux camps s’accusent mutuellement de harcèlement, et que certaines personnes des deux bords ont dû faire des pauses temporaires ou définitives de leur activité sur X (dans le même tweet, le membre ZEM&S se plaint d’avoir été mal reçu par des zététicien·nes parce qu’il demandait des sources ; il faut bien sûr rester ouvert à la critique, donner des sources comme je vais largement le faire ici, mais cela dépend aussi du ton et de l’aspect respectueux, constructif des critiques).

On m’a objecté justement que tout le monde croit que sa position ou ses connaissances sont meilleures moralement et épistémiquement que celles des autres (sinon on ne dirait rien), mais comme pour le fait que nous avons toutes et tous des idéologies, le point crucial c’est à des degrés divers, et c’est aussi le cas pour ce sentiment de supériorité, qui risque d’être plus fort pour toute position extrême ou militante :

Toner, K., Leary, M. R., Asher, M. W., & Jongman-Sereno, K. P. (2013). Feeling superior is a bipartisan issue: Extremity (not direction) of political views predicts perceived belief superiority. Psychological Science, 24(12), 2454–2462. https://doi.org/10.1177/0956797613494848

Cette posture morale est identique à celle d’une partie de l’extrême-gauche qui se définit comme progressiste (luttant à raison contre le racisme, l’homophobie, le sexisme et toute forme de discrimination, mais avec des méthodes critiquables) ou « woke » (dans le sens éveillé), mais que ses adversaires désignent comme « wokiste » (les deux camps peuvent utiliser « Social Justice Warriors » ou SJW). Il y a une revendication de supériorité morale très forte — ce qui horripile la partie de la gauche laïque, et en fait tous les autres bords politiques — chez ce courant, et tout ce qui se situe moins « à gauche » que lui sera considéré si pas comme « fasciste », du moins « faisant le lit du fascisme ». Ce militantisme est chez Tranxen (communication personnelle) justifié par la montée de l’extrême-droite, qui est certes un problème, mais on peut légitimement se demander si combattre un extrémisme par un autre est la bonne solution, parce que les excès manifestes de cette extrême-gauche (cancel culture, victimisation excessive et sensibilité excessive à la discrimination, comme considérer comme psychophobe UN sketch humoristique avec une camisole de force, essentialisme des identités sociales, déni de la liberté d’expression comme empêcher la tenue de conférences idéologiquement opposées, plutôt que de proposer des contre-manifestations, déboulonnage des statues au lieu de les expliquer ou de les déplacer dans un musée, vouloir réécrire ou mettre à l’index les œuvres littéraires du passé, menacer de mort une humoriste qui se moque des transgenres, etc.) sont du pain béni pour l’extrême-droite, qui va sans doute pouvoir recruter des gens plus centristes que de tels excès agacent. C’est bien sûr ici une question d’opinion, mais j’avance cet argument juste pour signaler que la posture morale supérieure n’est pas gage de justification politique.

Il faut souligner à propos de la forme qu’il existe quelques recherches montrant que des stratégie militantes radicales peuvent être utiles politiquement (ou pas), mais ici je questionne l’utilité des excès doctrinaires de l’EG et pas de ces stratégies liées au militantisme politique (à toutes fins utiles certaines de ces publications, à ma connaissance) :

Feinberg, M., Willer, R., & Kovacheff, C. (2020). The activist’s dilemma: Extreme protest actions reduce popular support for social movements. Journal of Personality and Social Psychology, 119(5), 1086–1111. https://doi.org/10.1037/pspi0000230

Fritz, L., Hansmann, R., Dalimier, B. et al. (2023). Perceived impacts of the Fridays for Future climate movement on environmental concern and behaviour in Switzerland. Sustain Sci 18, 2219–2244. https://doi.org/10.1007/s11625-023-01348-7

Shuman, E., Saguy, T., van Zomeren, M., & Halperin, E. (2021). Disrupting the system constructively: Testing the effectiveness of nonnormative nonviolent collective action. Journal of Personality and Social Psychology, 121(4), 819–841. https://doi.org/10.1037/pspi0000333

Simpson, B., Willer, R., Feinberg, M. (2022). Radical flanks of social movements can increase support for moderate factions, PNAS Nexus, Volume 1, Issue 3, pgac110, https://doi.org/10.1093/pnasnexus/pgac110

La deuxième caractéristique souvent reprochée à cette fraction de l’extrême-gauche est (2) sa virulence, qui est justifiée par la probité morale décrite ci-dessus et la perception du danger de la montée de l’extrême-droite. L’accusation est bien sûr reprise en miroir par les militant·es, qui se plaignent d’un harcèlement contraire. Mes échanges avec Tranxen nous donnent une bonne occasion d’évaluer ce point. Dans ma conférence, je critique les propos idéologiques sans base empirique, ainsi que les idéologies politiques extrêmes et leur intrusion dans la sphère zététique, en citant des collectifs comme le cercle Cobalt ou les ZEM. Tranxen répond en disant que ma conférence est digne de Raoult, dangereuse et s’apparente à de la désinformation scientifique, qui plus est sur la base d’éléments on le verra largement insuffisants et d’erreurs grossières — ce qui ne pourrait se justifier si le contenu de ma conférence était effectivement problématique (ainsi qu’on va pouvoir le juger ici).

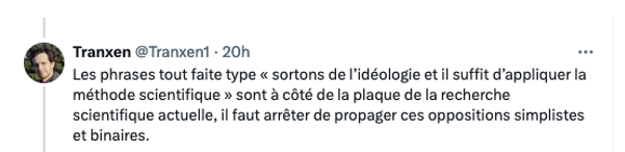

Il y a donc on le voit un hiatus sévère entre la posture soi-disant éthique défendue par les « Chevaliers Blancs » de la zététique, et leur mode de communication. Pire, je trouve très instructive la différence entre l’individu qui respecte autrui dans ses messages privés (comme Tranxen le dit, nous avons échangé poliment et constructivement dans des messages privés), et ce qu’il affiche publiquement sur son blog (ma conférence = désinformation scientifique), et de façon encore plus virulente sur X (Raoult et « précédent dangereux »). Dans ses messages privés, il me dit que « les sources [de ma conférence] sont bonnes et nombreuses », ou « sur le fond vos sources sont impeccables », et encore « Sur le fond du message final je vous rejoins : effectivement se rendre compte qu’on est impliqué sur un sujet doit nous rendre vigilant à ne pas tordre la réalité », ce qui me paraît entrer en contradiction avec le fait que je sois un Raoult de la psychologie, que ma conférence « crée un précédent dangereux », qu’elle induirait le public en erreur en propageant « une vision à côté de la plaque de l’état du débat scientifique », et qui « s’apparente à de la désinformation scientifique ». Déjà en parallèle de notre discussion privée dont je le remerciais pour le ton poli et constructif, il postait sur son compte X :

Je le rappelle de la part de quelqu’un qui a une connaissance bien plus faible que la mienne sur les biais cognitifs et les croyances en psychologie (ce qui est parfaitement normal, vu que ce n’est pas son domaine de compétences)… Je ne vois dans ce partiellement double discours pas seulement le fait que par messages directs, il est effectivement plus difficile de critiquer vertement autrui que sur les réseaux sociaux, mais également comme un symptôme de la « méthode idéologique », qui veut créer l’indignation de ses troupes par ses exagérations outrancières sur les réseaux sociaux.

J’avais déjà noté quelques outrances irrationnelles, radicales, militantes et extrémistes, de la part de la communauté ZEM&S, par exemple quand Pierre Jacquel (dont les connaissances de doctorant sur les biais cognitifs et croyances vont être évaluées ci-dessous) se permettait de critiquer publiquement mon livre (Bellevaut & Wagner-Egger, 2022) sur la base du texte de couverture (écrit par l’éditeur), en postant même un avis sur Amazon ! J’ai aussi gardé le tweet de tel ZEM traitant Thomas Durand de « tas de fumier » (sa seule défense serait si Thomas l’a insulté de la même manière et qu’il lui répondait, qu’on me transmette cette pièce à conviction), du même qui disait d’une de mes remarques portant sur la méthodologie « sa remarque hautaine est incroyablement stupide » (je demandais aux critiques de la mesure de position politique de faire une critique scientifique, à savoir proposer d’autres mesures et voir si les résultats changent, plutôt que d’opter pour la critique idéologique : « c’est une mesure insuffisante donc les résultats sont biaisés », ce qui est le propre de la méthode idéologique des antivax et autres complotistes, ces derniers me l’ont d’ailleurs faite à propos des travaux sur les croyances aux théories du complot, pour tenter de les discréditer). J’ai également sous le coude un tout récent tweet d’une sympathisante ZEM qui nous dit que « les zet de Youtube c’est une arnaque, ils ont jamais ouvert un papier scientifique sur les croyances. Il n’en ont même pas les bases ».

On l’a compris, comme pour la critique de Tranxen, je vois dans la forme de la méthode idéologique ce mélange d’arrogance, de propos complètement outranciers — certaines critiques partielles peuvent bien sûr être faites rationnellement et dans un respect minimal, comme Tranxen en privé mais pas sur les rs, et oui je vais reconnaître plus bas que moi aussi, j’ai utilisé quelques formules qui peuvent être ambiguës ou mal comprises, ce qui est parfaitement normal pour une conférence de 20 minutes —, accompagnés d’une connaissance lacunaire du domaine dont ils parlent. On peut suspecter ici un Dunning-Kruger ou biais de surconfiance, typique de la méthode idéologique :

Lackner, S., Francisco, F., Mendonça, C. et al. Intermediate levels of scientific knowledge are associated with overconfidence and negative attitudes towards science. Nat Hum Behav 7, 1490–1501 (2023). https://doi.org/10.1038/s41562-023-01677-8

Motta, M., Callaghan, T. & Sylvester, S. (2018). Knowing less but presuming more: Dunning–Kruger effects and the endorsement of anti-vaccine policy attitudes. Soc. Sci. Med. 211, 274–281.

Nicholas Light et al (2022). Knowledge overconfidence is associated with anti-consensus views on controversial scientific issues.Sci. Adv.8,eabo0038.

Vranic A, Hromatko I and Tonković M (2022) “I Did My Own Research”: Overconfidence, (Dis)trust in Science, and Endorsement of Conspiracy Theories. Front. Psychol. 13:931865.

Dernier point d’éthique concernant la forme de la critique, quand je vais personnellement sur un domaine où mes compétences sont à moitié valables (par exemple en épidémiologie, je peux comprendre les stats mais pas les variables), je pose des questions aux gens qui visiblement en savent plus que moi : Peut-on dire ceci ou cela ? D’une part, j’évite de ce fait l’arrogance et la surconfiance du débutant, et d’autre part, je reçois une réponse beaucoup plus constructive et polie (au même niveau de ma question). C’est un peu ce qui s’est passé dans les messages privés avec Tranxen où nous avons échangé des arguments, mais ses propos en ligne témoignent d’une radicalisation pour moi typique de la méthode idéologique (des extrêmes politiques et du militantisme).

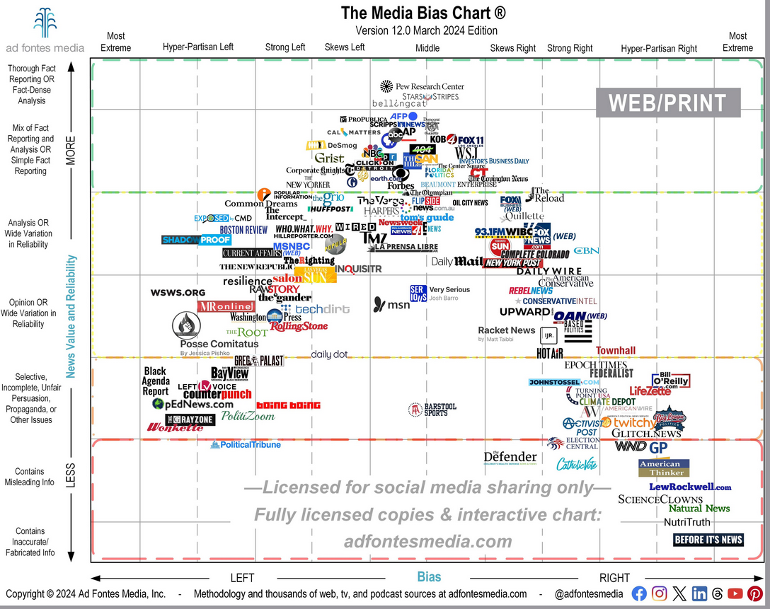

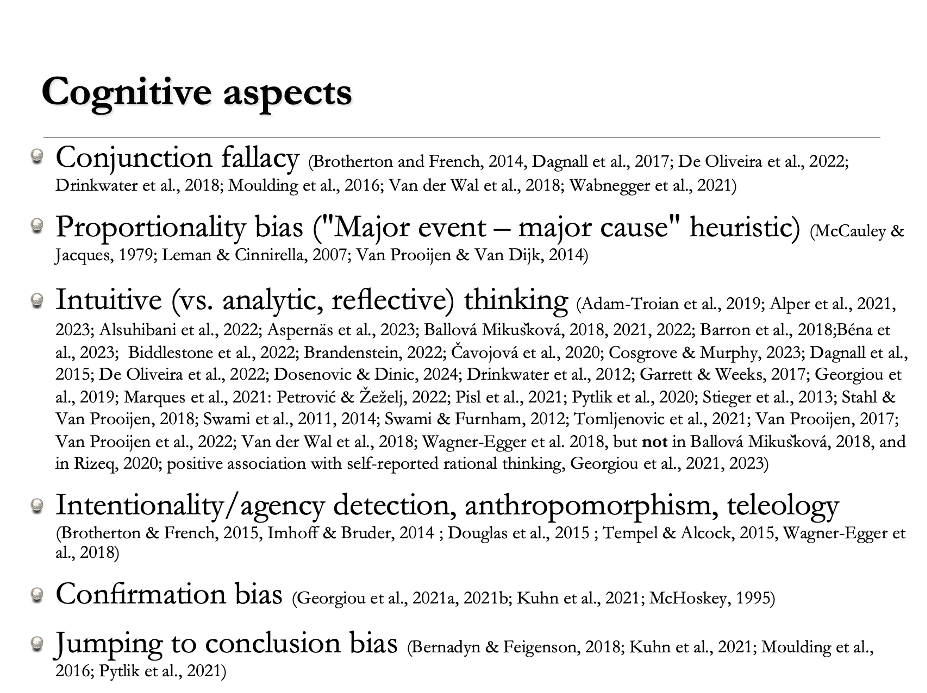

Sur le fond

Mon expertise est contestée sur deux points : (1) est-ce que les extrêmes politiques sont plus irrationnelles que les positions plus centristes, et (2) dans quelle mesure est-ce que les biais cognitifs sont liés aux croyances. Nous allons donc explorer plus en détails ce que disent les études sur ces deux points. Si Tranxen et d’autres peuvent me fournir un plus grand nombre d’articles scientifiques qui montrent l’inverse, alors elles et ils auront prouvé ce qu’ils avancent, que je défends une position minoritaire, et auront prouvé également la rationalité de leur point de vue et action dans le domaine de l’esprit critique. Si par contre il ne sont pas en mesure de le faire, nous serons dans le cas d’une critique et d’une méthode que j’appelle idéologique (en plus d’être lacunaire).

Ma thèse principale : les méthodes scientifiques (quantitatives en sciences sociales) permettent d’atténuer les idéologies que nous avons toutes et tous à des degrés divers, ce qui est d’autant plus important dans le domaine des SHS où les idéologies politiques abondent.

Dans ce texte, j’utiliserai le concept d’idéologie au sens général du concept, selon le Larousse : « Système d’idées générales constituant un corps de doctrine philosophique et politique à la base d’un comportement individuel ou collectif ». Comme exemples, nous pouvons penser aux idéologies politiques (d’extrême gauche, extrême droite, de centre gauche, de centre droite, du centre, libéralisme, communisme, conservatisme, anarchisme, libertarianisme, etc.), religieuses (créationnisme, intégrisme, etc.), ésotériques (p.ex. New Age), ou complotistes (p.ex. QAnon).

La méthode commune à toute les idéologies est celle que décrit Delouvée (2015) à propos du conspirationnisme : la conclusion est donnée dès le départ, et l’on va chercher tous les éléments concordants avec cette conclusion. A l’inverse, la méthode scientifique se veut plus constructive (elle tend du moins à cet idéal), les scientifiques vont former une conclusion au terme d’une série d’études ou de décennies de recherches (méta-analyses, consensus scientifique). Hygiène Mentale en avait fait un schéma utile :

La science est par essence anti-idéologique, non pas que les scientifiques n’aient pas d’idéologie, au contraire, de nombreux scientifiques sont religieux, communistes, libéraux, etc. Ce que je dis dans ma conférence et que je précise encore dans l’entretien avec Mr. Sam — qui était fait pour dissiper certains malentendus de la courte conférence, comme le fait que je renverrais dos-à-dos extrême-gauche et extrême-droite, ce qui est le cas seulement sur certains points, mais de loin pas complètement —, c’est que nous avons toutes et tous des idéologies, et que la méthode scientifique permet de les atténuer (« les méthodes quantitatives sont un bon moyen d’échapper en partie à nos idéologies » vers 4min15), de par le recours aux données empiriques qui peuvent contredire notre idéologie, ainsi que par la confrontation sociale à d’autres expert·es et la formation d’un éventuel consensus ou opinion majoritaire. C’est le même point de vue que celui du philosophe Gaston Bachelard (1967) pour qui la méthode scientifique permet aux scientifiques de lutter contre les « obstacles épistémologiques » de la pensée naïve, et la liste qu’il donne ressemble de près à ce que l’on appelle actuellement biais cognitifs. Max Weber définissait dans « Le savant et le politique » la neutralité axiologique qui dit que la chercheuse ou le chercheur doivent dans leur travaux de recherche se montrer autant que possible sceptique ou apolitique, distant·e face à toute thèse normative — ce qui est bien sûr impossible à 100% — mais bien entendu pas forcément sur la place publique.

Je défends donc principalement l’idée que la méthode scientifique ne peut et ne doit pas seulement être utilisée dans le domaine des sciences naturelles et de l’exploration du paranormal, comme cela a été classiquement le cas pour la zététique, mais également dans le domaine social et politique. Ainsi, les hypothèses, théories, idéologies sociales et politiques ne doivent pas seulement reposer sur des arguments et des auteurs célèbres qui les soutiennent, mais également sur la confrontation à des données empiriques. Ceci constitue d’abord une critique notamment des sociologies et idéologues d’extrême gauche (ou extrême droite), qui comme par exemple Lordon (2017) ne donnent aucune donnée empirique à l’appui de leurs thèses. Certains de leurs arguments peuvent bien entendu être corrects, mais il n’y a aucun garant qu’ils le soient, autre que l’aura de l’auteur ou la force subjective perçue des arguments. Dans ce sens, les idées, théories, etc., dont certaines peuvent provenir d’une idéologie, sont bien entendu utiles et même indispensables à la démarche scientifique qui est comme on sait hypothético-déductive, mais aussi inductive, les hypothèses et théories naissent des résultats empiriques précédents, mais à titre d’hypothèses à tester. On connait bien le cas où même des idéologies religieuses ont mené à des découvertes scientifiques, lesquelles bien sûr s’opposent finalement à la doctrine religieuse de départ, comme le moine Mendel et sa découverte des lois de la génétique. L’idéologie peut donc être utile seulement si elle est empiriquement évaluée (sinon elle reste dans le domaine de l’idéologie).

La critique de Tranxen par rapport à cette thèse principale constitue sa première erreur (erreur#1), qui n’est autre que la technique de l’épouvantail classique (homme/femme de paille) dans les débats politiques et encore plus sur les réseaux sociaux, qu’il m’attribue par ailleurs (ce que nous évaluerons plus loin) :

J’avance dès les premiers mots de la conférence que (a) nous avons toutes et tous, à des degrés divers, des idéologies, y compris au centre de l’échiquier politique (à moins de 2 min : « … nos positions idéologiques, politiques existent [chez] toutes et tous… »), et que (b) la méthode scientifique même en sciences sociales permet de les atténuer. Mais également que (c) les biais et idéologies et leurs risques d’erreurs — tordre la réalité pour qu’elle s’adapte à l’idéologie, plutôt que de tenter d’inférer son idéologie à partir de la réalité — seront d’autant plus forts si nous soutenons une idéologie plus extrême ou plus radicale politiquement, puisque la conclusion que nous défendons sera d’autant plus importante pour notre identité, voire notre existence. Ainsi, l’expression « zetapo » (« zététique apolitique ») n’est qu’un épouvantail assez grossier — il faudrait écrire plutôt zetmoinpo, « zététique moins politisée ». C’est ce que reconnaissait Tranxen dans ses messages privés, et il est instructif qu’il fasse un épouvantail au lieu de relever ce point d’accord (ou alors il a changé d’avis depuis).

Un bon argument avancé par Tranxen contre ma thèse principale est l’article d’opinion très intéressant (mais pas très nouveau, ces arguments existent depuis les années 60, dès les premiers travaux de Kahneman et Tversky ou Wason, cf. Wagner-Egger 2011) de Morais et Hertwig, des spécialistes du domaine, qui affirment que les méthodes expérimentales ne sont pas neutres, en donnant l’exemple des biais cognitifs dans le raisonnement probabiliste (on ne parle cependant pas ici du raisonnement logique et de tous les autres biais cognitifs) seraient dus à un choix méthodologique, de nombreuses recherches montrant que le raisonnement probabiliste n’est pas biaisé, d’autres (celles basées sur les méthodes de Tversky et Kahneman) démontrant l’existence de biais. Morais et Hertwig défendent également l’idée qu’il y aurait eu du fait de l’utilisation plus facile de la méthodologie de Tversky et Kahneman un biais dans les recherches sur le sujet en faveur de la position pro-biais, et que donc ce courant a exagéré l’irrationalité supposée de l’être humain. Ces auteurs concluent pourtant de façon « centriste » que pour que les gens aient de meilleurs intuitions statistiques (mais pourquoi le faire s’ils en ont déjà des bonnes ? Cela veut dire qu’une part des inférences sont tout de même erronées), il faut utiliser les outils de la littérature pro-biais (« nudging »), mais aussi de la littérature anti-biais (« boosting »).

Il faut noter qu’en fait, contrairement à ce que suggère Tranxen (erreur#2), cet argument ne réfute pas ma thèse principale. Je ne dis pas que telle ou telle méthode expérimentale va toujours produire des résultats qui diminuent ou annulent nos éventuels idéologies, biais ou croyances, je dis que LES méthodes empiriques (toutes les méthodes possibles, pas une seule en particulier) concourent à lutter contre nos préconceptions. C’est bien ce qui s’est passé dans le courant des heuristiques et biais, puisque ce sont d’autres méthodes expérimentales différentes qui permettent de dire que parfois voire souvent, nos intuitions statistiques sont bonnes (je vais développer ce point plus bas à propos des biais cognitifs).

Il faut noter aussi que les recherches du courant heuristiques et biais ne sont pas idéologiquement orientées autant que le sont les affirmations idéologiques sans preuves : au départ, il n’y avait pas de volonté de montrer que les gens font des erreurs et sont irrationnels, ou même s’il y en avait une (il faudrait une étude historique sur la genèse des travaux de Kahneman &Tversky), celle-ci ne pouvait pas être supportée sans que les résultats de milliers de recherches, avec des méthodes différentes, montrent un tel résultat (et ces recherches auraient pu aboutir à montrer que les gens ne sont pas biaisés). Donc ici l’idéologie dont on parle (les humains seraient en grande partie irrationnels) est, grâce à la méthode empirique, bien moins idéologique que des propositions semblables sans aucune donnée scientifique, et d’autre part, les limites de ces méthodes peuvent être découvertes par l’utilisation d’autres méthodes qui aboutissent à des résultats différents. Une théorie basée sur de nombreuses données empiriques issues d’un petit nombre de méthodes — dont la recherche ultérieure découvrira ou non les limites en utilisant d’autres méthodes — fait partie intégrante de la méthode et du progrès scientifique.

La seule position que fragilise les arguments de Morais et Hertwig est celle qui dirait que l’être humain est fondamentalement irrationnel dans le domaine du raisonnement statistique. Mais nous discuterons plus loin à propos des biais des autres domaines où cette discussion a lieu (raisonnement logique, croyances religieuses, paranormales, complotistes, aux fake news, au bullshit, croyances antiscience, etc.).

A ce stade, définissons la rationalité, parce que Tranxen se trompe également (erreur#3) sur ce point. Dans son article de critique sur Gérald Bronner de son blog, il écrit dans un puissant élan de relativisme :

« De plus, quand GB critique les complotistes ou les propagateurs de fake-news, il a souvent un discours disant « il faut éduquer la population à l’esprit critique, pour que les gens apprennent le consensus scientifique et faire la différence entre le vrai et le faux, la croyance et le factuel ». Sur le principe, très bien ! Mais en pratique, son discours et sa manière de voir cette éducation à l’esprit critique semblent ignorer la recherche en sciences de l’éducation, en linguistique ou en épistémologie, où une séparation claire vrai/faux est dépassée depuis genre… Hume et Laplace? Probablement avant à vrai dire, mais toujours est-il que parler « Du Vrai » comme si c’était évident et facile à atteindre est très naïf. »

A mon avis, on ne peut pas parler de sciences, d’esprit critique, ou de connaissance, ou même de quoi que ce soit sans « faire la différence entre le vrai est le faux ». Que le vrai soit difficile à atteindre est ce que montre toute l’histoire des sciences, celle des biais cognitifs et des erreurs de raisonnement, mais de là à avancer l’idée qu’on ne peut pas affirmer ce qui est vrai et faux (avec bien sûr de larges zones grises), on part dans le plus pur relativisme d’extrême gauche (celui de certains sociologues des sciences, etc.). Sans parler des croyances factuelles dont il est facile de savoir si elles sont vraies ou fausses (il y a du soleil aujourd’hui), il y a des connaissances sans doute définitivement vraies — ou de façon très improbablement fausses, jamais définitivement peut-être mais une certitude à 99,999% est une quasi-certitude — dans le domaine scientifique (le corps est composé de cellules, les espèces évoluent, la Terre et les planètes sont en forme de boules, etc.). Il y a bien sûr comme le relevait Etienne Klein pendant la pandémie la recherche en cours qui est bien plus incertaine, mais les sciences nous apportent les moins mauvaises méthodes pour s’éloigner de l’erreur (le fameux « it works, bitches » de Dawkins). Donc il y a une séparation claire du (très probablement) vrai et faux, avec à l’entre-deux une grande zone grise (l’erreur de Tranxen est de penser que cette zone grise empêche de parler du vrai et du faux), et il y a des méthodes et des théories scientifiques qui sont admises pour arriver (difficilement) à séparer le faux du vrai.

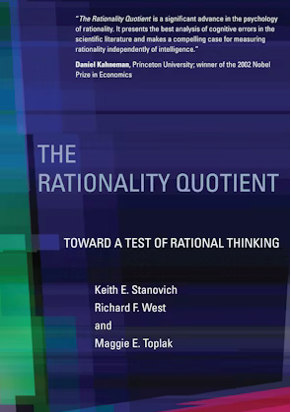

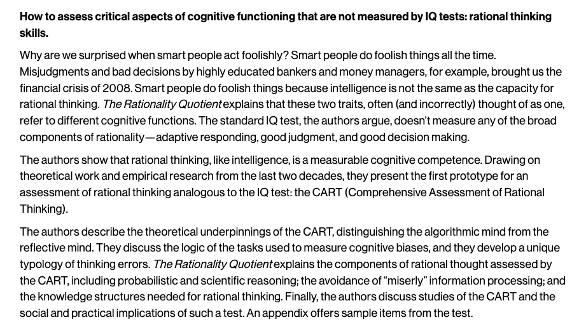

Ainsi, il existe bel et bien une rationalité définie précisément en psychologie du raisonnement, que je n’ai pas eu le temps d’aborder dans ma conférence, mais que j’aborde dans l’entretien avec Mr. Sam (et dans mon livre sur les biais, Bellevaut & Wagner-Egger, 2022), et donc l’affirmation de Tranxen : « Là encore c’est un problème de ne pas définir des mots aussi polysémiques que rationnel : chacun y voit quelque chose de différent, et on a vite fait de conforter les préjugés des uns et des autres » constitue son erreur#4. Mais comme il ne travaille pas dans ce domaine, il est normal qu’il ne connaisse pas ou peu la littérature sur le raisonnement de ces 60 dernières années — il devrait néanmoins être d’autant plus prudent dans ses affirmations.

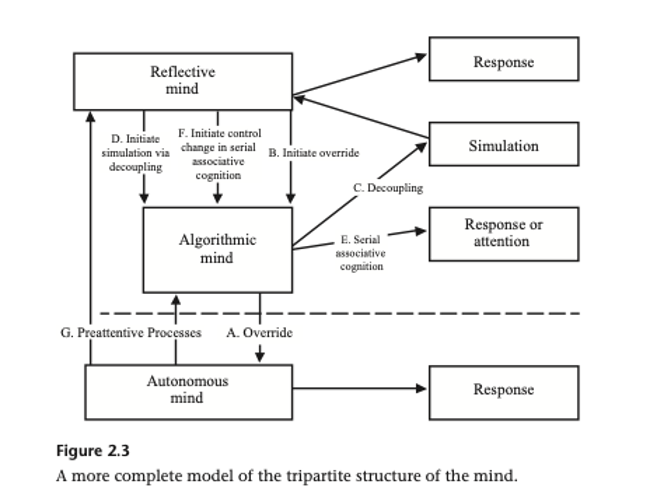

En psychologie du raisonnement, on définit très précisément la rationalité2, celle en rapport avec le Système 2 (pour moi la véritable rationalité, les autres sont des rationalités en un sens bien plus faible que l’on devrait nommer autrement, fonctions, ou justifications), qui est mesurée par l’écart entre la réponse et une théorie normative acceptée dans le domaine scientifique. Ainsi, l’arithmétique donne des réponses normativement correctes dans le domaine du calcul, la théorie des probabilités (classique ou bayésienne) dans le domaine des probabilités, la logique dans le domaine du raisonnement logique, etc. Quand on mesure la rationalité, on prend de nombreuses tâches dont la réponse correcte est acceptée — oui il peut y avoir des tâches dont la réponse correcte est contestable, on ne les prendra pas en compte. Par exemple, pour établir un jugement de contingence correct entre deux événements A et B, la réponse normative nous dit qu’il faudra prendre en compte les fréquences des quatre cases du tableau (A et B, non A et B, non B et A, non A et non B) dans le calcul. Même les critiques des biais cognitifs utilisent quantité de théories normatives dans leur étude, en ce qui concerne l’analyse statistique des résultats par exemple.

D’autre formes de rationalité ont bien entendu été proposées par les psychologues, sociologues ou économistes (rationalité axiologique, utilitariste, etc.), en psychologie on parle par exemple de rationalité1, en rapport avec le Système 1. Cette rationalité1 caractériserait les raisonnements efficaces pour (a) la survie de l’espèce (rationalité adaptative) ou (b) les buts de l’organisme au niveau psychologique ou pragmatique (Evans et Over, 1997). Ainsi, les humains pourraient très bien être irrationnels2, mais rationnels1, comme dans le cas du biais (ou heuristique) de corrélation illusoire, qui est un raisonnement scientifiquement invalide, mais qui peut assurer la survie de l’organisme (bruit = danger). Personnellement, je trouve que cette façon de parler souffre de sérieuses limitations, cela amènerait à penser que la rationalité1 est aussi importante que la rationalité2, ce qui pour moi est loin d’être le cas. Johnson-Laird a par exemple critiqué la profusion possible de rationalités, puisqu’il suffit de trouver un critère pour en inventer une (rationalité musicale, kinesthésique, linguistique, etc.), ce qui confine à la tautologie (je peux toujours trouver une forme de rationalité pour tout comportement). De plus, la rationalité2 est supérieure à toute autre forme de rationalité1 du fait que la méthode scientifique est la seule méthode qui a permis aux humains de découvrir quelque chose de vrai sur le monde. Les formes de rationalité alternatives sont bien différentes de la rationalité2, laquelle implique un raisonnement conscient, des efforts cognitifs d’apprentissage et de concentration, ainsi que des siècles de découvertes mathématiques et scientifiques. Tandis qu’un comportement lié à la survie (comme la recherche de partenaires sexuels) n’implique que certains comportements relativement automatiques ou un peu vains (comme le culte de l’apparence, la séduction, etc.), soit des aptitudes certainement moins remarquables — même si oui, la parade nuptiale du paradisier est très belle, cela n’est toutefois pas comparable au niveau épistémologique à la démonstration mathématique de la conjecture de Riemann ! De même, le fait pour un individu de satisfaire ses propres buts égoïstes (rationalité1 pragmatique) est bien moins remarquable que les raisonnements mathématiques et scientifiques. Comparer les buts et fonctions psychologiques, évolutionnistes, sociaux avec les théories scientifiques construites par un effort collectif de millions de savant·es pendant des millénaires me paraît très discutable. Je préfère dire que si certaines réponses sont irrationnelles2 (donc irrationnelles au vrai sens du terme), elles peuvent bien sûr avec des fonctions adaptatives, pragmatiques, psychologiques, sociales, politiques, etc. (mais je n’appellerais pas ces fonctions rationalités, ou alors je rappellerais la supériorité ou l’incomparabilité de la rationalité2 au niveau épistémologique si je cite d’autres formes de rationalité).

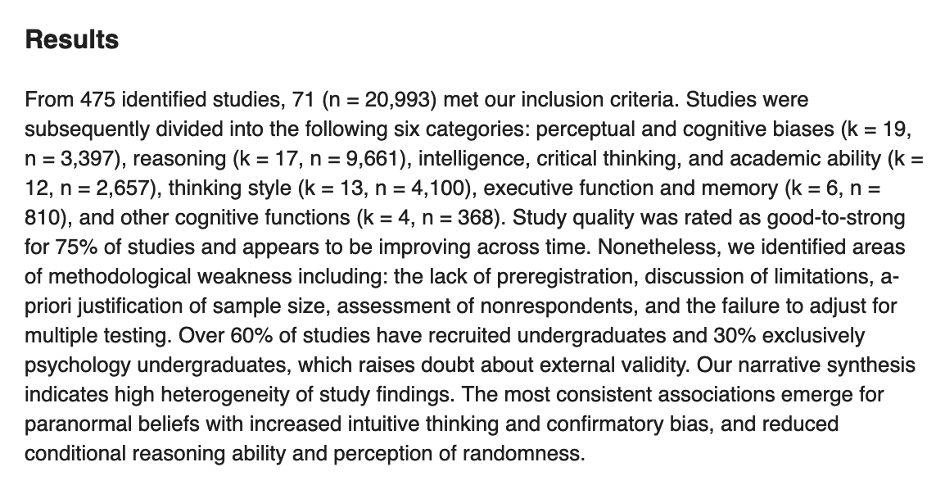

Donc oui, certaines réponses, certaines croyances sont irrationnelles2, des erreurs d’un point de vue scientifique (par exemple interpréter une coïncidence par un lien de causalité ; cela peut être le cas, mais il faut plus de preuves), et les résultats du CRT (Cognitive Reflection Test) mesurant la pensée analytique se mesurent en nombre d’erreurs : une pensée plus analytique commet moins d’erreurs, une pensée plus intuitive commet davantage d’erreurs dans cette tâche. Les croyances (paranormales, religieuses, complotistes, extrémistes) peuvent aussi être considérées comme irrationnelles, parce qu’elles reposent sur des preuves que les scientifiques jugent insuffisantes (coïncidences, intuitions, ressentis, anomalies apparentes, heuristiques « à qui profite le crime », , et elles violent des principes scientifiques très importants comme le rasoir d’Ockham et le fardeau de la preuve (qu’on peut déduire du théorème de Bayes ; Cf. Wagner-Egger, 2021, à propos des théories du complot).

Mes thèses secondaires :

Passons maintenant aux différents points de critiques de Tranxen. Le titre lui-même de son article « La recherche sur les biais pour faire disparaitre son idéologie ? » contient déjà deux erreurs (!), les fameux épouvantails très communs dans tout débat politique — sans doute plus fréquents aux extrêmes, mais il est possible que j’en fasse aussi, on le verra plus loin. J’ai déjà mentionné que je ne prétends pas « faire disparaître l’idéologie » (erreur#1), et ce n’est pas la « recherche sur les biais » (erreur#5). Je dis que la recherche quantitative (en sociologie et psychologie) dans son ensemble permet de diminuer ses a priori idéologiques, pas seulement la recherche sur les biais.

Ma thèse #1 : L’extrémisme affaiblit la rationalité.

Le texte de Tranxen est truffé d’erreurs et d’approximations. Cela commence par :

« Le propre de la psychologie politique est de croiser des positions politiques (conservatisme, attrait pour l’autorité, l’égalité, etc) et des caractéristiques psychologiques (anxiété, peur de l’inconnu, capacité d’empathie, etc). Quand en politique on parle « des extrêmes », on mélange généralement deux choses : les « gens sur les bords de l’axe gauche-droite » (analyse de leurs idées), et les « gens qui défendent leurs idées de manière trop dogmatique » (analyse de leur psychologie) ».

Personne ne mélange ces deux choses, et cette phrase suggère que c’est Tranxen qui se « mélange les pinceaux ». D’abord les études scientifiques ne « parlent » pas des extrêmes, elles définissent l’extrémisme politique par l’auto-positionnement sur l’axe politique gauche-droite : On demande aux gens de se placer eux-mêmes sur un axe allant de l’extrême-gauche (notée ci-après EG) à l’extrême-droite (notée ci-après ED) en passant par le centre, typique sur une échelle de 1 = EG à 7 = ED, en passant par le centre (4). Dissipons ici aussi une critique que m’ont fait d’autres ZEM&S : si cette mesure n’était pas pertinente (c’est en fait la plus importante, qu’elle soit suffisante ou non), les gens n’y répondraient pas, vu qu’on laisse la possibilité de ne pas répondre. Ensuite, on demande aussi ce qu’ont voté les gens aux dernières élections, ou leur intention de vote dans un futur proche. Si comme on me l’a suggéré ces mesures sont insuffisantes pour rendre compte des attitudes politiques — c’est même certain, toute science simplifie la réalité par définition, c’est le principe de base du réductionnisme, dans certaines études nous distinguons conservatisme économique et social par exemple, opur voir si cela change ou non les résultats (Nera et al., 2021) —, il ne faut pas se contenter de la méthode idéologique qui dit « vos mesures des attitudes politiques sont insuffisantes, donc vos études sont fausses », mais il faut user de la méthode scientifique. Si je pense que vos mesures sont insuffisantes, à moi le fardeau de la preuve de publier une étude similaire en ajoutant d’autres mesures qui montrent que les résultats changent. Tant que ce n’est pas fait, on garde les résultats des études actuelles (sous réserve de modifications éventuelles futures), parce que comme chacun·e sait, ce qui est avancé sans preuves peut être rejeté sans preuves.

La psychologie politique ne confond donc pas la position extrême sur l’axe gauche-droite avec les « gens qui défendent leurs idées de manière trop dogmatique » (analyse de leur psychologie) (erreur#6) : la psychologie politique fait des études quantitatives pour voir si la position politique est liée à des caractéristiques individuelles (comme le dogmatisme) ou sociales (comme le recours à des stratégies de protestation non normative comme le recours à la violence, etc.), et ensuite procède à des méta-analyses ou des synthèses des études effectuées.

Tranxen commet l’erreur#7 juste après en affirmant : « Or, les auteurs mettent plutôt en garde contre le fait de parler d’irrationalité pour qualifier certaines opinions ». Dans sa note 8, il nous parle d’abord du conservatisme dans son ensemble, alors que je parle de Rigidité mentale (dogmatisme, intolérance à l’ambiguïté et à l’incertitude, inflexibilité, manque de complexité) qui n’est pas une croyance, mais une forme de « style cognitif ». Il ne peut y avoir aucun débat sur le fait que ce style cognitif est irrationnel, comme je l’ai rappelé à propos de l’erreur#4 (il existe des normes assez précises de rationalité). Pour parler du conservatisme puisque Tranxen aborde cet autre sujet, il s’agit d’un idéologie politique qui oui peut avoir ses justifications (personnelles, politiques, sociales), mais ne rendra pas la rigidité mentale rationnelle2 (d’ailleurs la flexibilité mentale fait partie des vertus épistémiques dans le champ de l’esprit critique).

Cette question renvoie pour moi à un problème plus général de l’EG face aux notions de vérité, de rationalité dans le domaine du savoir scientifique et de la zététique, qui est que l’EG a pour ADN politique (et c’est moralement bien sûr soutenable, c’est également mon cas, mais dans les limites du savoir scientifique) de défendre les opprimés du « Système », les minorités, les femmes, les travailleurs et ouvriers, face à la discrimination, aux inégalités sociales, etc. Mais quand les recherches scientifiques montrent que ces minorités sont moins rationnelles — au sens très bien défini développé plus haut rationnelles2 — par exemple que les femmes ont pour toutes sortes de raisons sociales des croyances paranormales plus élevées que les hommes (à part en ce qui concerne les OVNIs et autres E.T., où on observe une différence inverse ; cf. Irwin, 2009), ou que les gens en bas de l’échelle sociale (plus grande précarité, dans les pays où les inégalités sociales sont plus fortes, niveau d’éducation plus bas, etc.) croient davantage aux théories du complot, cela met idéologiquement l’EG face à un dilemme « sociocognitif » : soit on fait du cherry-picking dans les études scientifiques pour ne garder que les études qui vont à l’encontre du consensus scientifique et défendre qu’il n’y a pas moins de rationalité (méthode idéologique), soit on dénie toute validité aux études en disant que c’est l’idéologie des auteurs qui s’exprime (méthode idéologique antiscience), soit encore on définit d’autres formes de rationalité pour dire qu’en un autre sens, ces gens sont rationnels (mais c’est une erreur, comme je l’ai argumenté ci-dessus une inférence peut très bien être rationnelle1 ou en un autre sens, cela ne la rendra pas rationnelle2, elle restera donc irrationnelle2). Mais la méthode scientifique, quand il s’agit d’études répétées et concordantes, nous oblige à reconnaître la validité (partielle, et souvent provisoire) de cet ensemble de recherches, et à accepter dans certains cas une relative irrationalité des minorités que l’on défend, quitte à expliquer cette irrationalité par des facteurs sociaux (il paraît évident que la domination masculine a opéré et opère toujours dans le champ scientifique, et en a rendu l’accès aux femmes difficile, etc.), mais il faut pas exclure d’autres facteurs — c’est encore une fois à la recherche et pas à l’idéologie de statuer. Il faut aussi noter que les recherches sur le complotisme ne montrent en majorité pas de différences de genre (en fait certaines études pas de différences, d’autres études une différence dans un sens et d’autres dans l’autre sens), il s’agit donc bel et bien d’études scientifiques et pas d’idéologie. Détecter certaines formes d’irrationalité ou de biais cognitifs n’est pas « élitiste », comme l’EG le reproche parfois, puisque tout le monde est victime à des degrés différents des biais ou de l’idéologie politique. Mais nier le fait qu’il existe des croyances rationnelles et irrationnelles est tout simplement antiscientifique et d’un relativisme irrationnel (les paradoxes du relativisme sont bien connus, cf. Raynaud, 2018).

Le dogmatisme, la rigidité mentale telles que définies en psychologie sont sans conteste aucun irrationnelles2 : il s’agit d’attitudes qui sont contraires à la recherche rationnelle de vérité, puisque dans ce qu’on mesure par là, il faut entendre des dimensions comme la rigidité mentale (difficulté à réviser ses croyances), intolérance à l’ambiguité, complexité cognitive faible, évitement de l’incertitude, etc. Stanovich et collègues (2016) montrent d’ailleurs que deux échelles de ce type (« deliberative thinking » et « open-minded thinking ») sont significativement liées à l’évitement d’une liste de biais cognitifs, à la pensée analytique, et négativement aux croyances antiscientifiques, paranormales et complotistes, donc à la définition de la rationalité2.

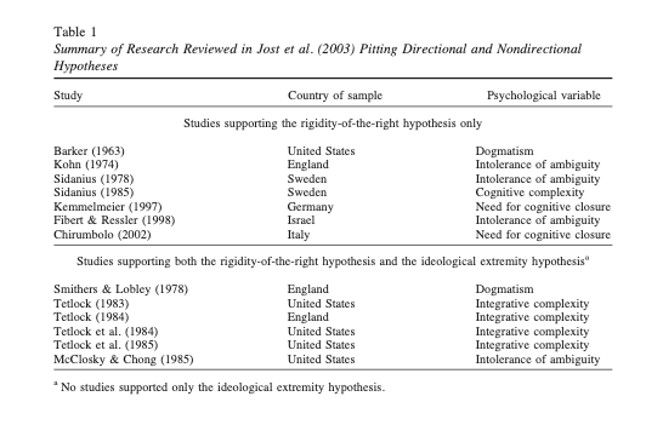

Dans la suite de son texte, Tranxen reprend ce graphique de ma conférence, auquel il ajoute une légende :

A ce point de la discussion, nous pouvons demander dorénavant à Tranxen d’appliquer surtout et en premier à lui-même ses leçons arrogantes de bonne vulgarisation, et de s’occuper des erreurs manifestes (erreur #8) que sa méconnaissance de la littérature commettent : ce graphique n’a absolument pas « été créé par PWE pour illustrer sa conférence » comme seul un cancre pourrait l’affirmer, il figure dans l’article cité de Jost et collègues, qui répondent aux commentaires sur leur méta-analyse. Alors je veux bien que ça ne change pas le fond du problème (ça va juste faire mieux accepter idéologiquement le graphique quand il vient d’une source de préférence), mais ça prouve tout de même que Tranxen n’a pas lu les 3 premiers articles du débat que je cite dans ma conférence. Je trouve assez sidérant mais révélateur le contraste entre un tel niveau d’amateurisme et la gravité des accusations contre moi…

Donc nous avons (1) la thèse (méta-analyse de Jost et al. montrant plus de rigidité à droite), (2) l’anti-thèse (réponse de Greenberg et al. qui résument les études montrant plus de rigidité aux 2 extrêmes), et (3) la synthèse de Jost et al. :

(1) Jost, J. T., Glaser, J., Kruglanski, A. W., & Sulloway, F. J. (2003). Political conservatism as motivated social cognition. Psychological Bulletin, 129(3), 339–375. https://doi.org/10.1037/0033-2909.129.3.339

Abstract

Analyzing political conservatism as motivated social cognition integrates theories of personality (authoritarianism, dogmatism-intolerance of ambiguity), epistemic and existential needs (for closure, regulatory focus, terror management), and ideological rationalization (social dominance, system justification). A meta-analysis (88 samples, 12 countries, 22,818 cases) confirms that several psychological variables predict political conservatism: death anxiety (weighted mean r=.50); system instability (.47); dogmatism-intolerance of ambiguity (.34); openness to experience (-.32); uncertainty tolerance (-.27); needs for order, structure, and closure (.26); integrative complexity (-.20); fear of threat and loss (.18); and self-esteem (-.09). The core ideology of conservatism stresses resistance to change and justification of inequality and is motivated by needs that vary situationally and dispositionally to manage uncertainty and threat.

(2) Greenberg, J., & Jonas, E. (2003). Psychological motives and political orientation–The left, the right, and the rigid: Comment on Jost et al. (2003). Psychological Bulletin, 129(3), 376–382. https://doi.org/10.1037/0033-2909.129.3.376

Abstract

Presenting an impressive model based on a large body of evidence, J. T. Jost, J. Glaser, A.W. Kruglanski, and F. J. Sulloway (2003) proposed that political conservatism uniquely serves epistemic, existential, and ideological needs driven by fears and uncertainties. The authors offer an alternative view based on conceptual considerations, historical events, features of communist ideology and practice, and additional social science research not reviewed by Jost et al. (2003). First, the authors take issue with Jost et al.’s (2003) description of the two core components of political conservatism. Second, they propose that the motives in the model are equally well served by rigid adherence to any extreme ideology regardless of whether it is right wing or left wing.

(3) Jost, J. T., Glaser, J., Kruglanski, A. W., & Sulloway, F. J. (2003). Exceptions that prove the rule–Using a theory of motivated social cognition to account for ideological incongruities and political anomalies: Reply to Greenberg and Jonas (2003). Psychological Bulletin, 129(3), 383–393. https://doi.org/10.1037/0033-2909.129.3.383

Abstract

A meta-analysis by J. T. Jost, J. Glaser, A. W. Kruglanski, and F. J. Sulloway (2003) concluded that political conservatism is partially motivated by the management of uncertainty and threat. In this reply to J. Greenberg and E. Jonas (2003), conceptual issues are clarified, numerous political anomalies are explained, and alleged counterexamples are incorporated with a dynamic model that takes into account differences between « young » and « old » movements. Studies directly pitting the rigidity-of-the-right hypothesis against the ideological extremity hypothesis demonstrate strong support for the former. Medium to large effect sizes describe relations between political conservatism and dogmatism and intolerance of ambiguity; lack of openness to experience; uncertainty avoidance; personal needs for order, structure, and closure; fear of death; and system threat.

Dans leur synthèse, Jost et al. reconnaissent que la moitié environ des études conclut à une « rigidité de la droite », et l’autre moitié au pattern c du graphique (rigidité de la droite + rigidité des extrêmes).

Ces travaux datent de 2003, et Tranxen qui les a déjà mal lus ne connait pas l’ensemble des autres travaux qui ont été menés depuis sur cette question (et encore une fois, c’est parfaitement normal, ce qui est anormal c’est sa prétention à penser connaître le domaine sans exercer la profession).

Voici une liste des travaux en plus des 3 ci-dessus qui me font faire dans ma conférence, comme synthèse des études, le pattern c de Jost et al., le U qui penche à droite (rigidité de la droite + rigidité des extrêmes) :

Bayrak, F., Dogruyol, B., Alper, S., Yilmaz, O. (2023). Multidimensional intuitive–analytic thinking style and its relation to moral concerns, epistemically suspect beliefs, and ideology. Judgment and Decision Making, 18:e42. doi:10.1017/jdm.2023.45

Brandt, M. J., & Sleegers, W. W. A. (2021). Evaluating Belief System Networks as a Theory of Political Belief System Dynamics. Personality and Social Psychology Review, 25(2), 159-185. https://doi.org/10.1177/1088868321993751

Bowes, S. M., Clark, C. J., Conway, L. G., III, Costello, T. H., Osborne, D., Tetlock, P., & van Prooijen, J. (2023, June 27). An Adversarial Collaboration on the Rigidity-of-the-Right, Rigidity-of-Extremes, or Symmetry: The Answer Depends on the Question. https://doi.org/10.31234/osf.io/4wmx2

Conway, L. G., Houck, S. C., Gornick, L. J., & Repke, M. A. (2018). Finding the Loch Ness Monster: Left-Wing Authoritarianism in the United States. Political Psychology, 39(5), 1049–1067. http://www.jstor.org/stable/45094449

Costello, T. H., Bowes, S. M., Baldwin, M. W., Malka, A., & Tasimi, A. (2023). Revisiting the rigidity-of-the-right hypothesis: A meta-analytic review. Journal of Personality and Social Psychology, 124(5), 1025–1052. https://doi.org/10.1037/pspp0000446

Costello, T. H., Bowes, S. M., Stevens, S. T., Waldman, I. D., Tasimi, A., & Lilienfeld, S. O. (2022). Clarifying the structure and nature of left-wing authoritarianism. Journal of Personality and Social Psychology, 122(1), 135–170. https://doi.org/10.1037/pspp0000341

Ditto, P. H., Liu, B. S., Clark, C. J., Wojcik, S. P., Chen, E. E., Grady, R. H., Celniker, J. B., & Zinger, J. F. (2019). At Least Bias Is Bipartisan: A Meta-Analytic Comparison of Partisan Bias in Liberals and Conservatives. Perspectives on Psychological Science, 14(2), 273-291. https://doi.org/10.1177/1745691617746796

Imhoff, R., Zimmer, F., Klein, O., António, J. H., Babinska, M., Bangerter, A., … & Van Prooijen, J. W. (2022). Conspiracy mentality and political orientation across 26 countries. Nature Human Behaviour, 6, 392-403. https://doi.org/10.1038/s41562-021-01258-7

Jost, J.T. (2017), Ideological Asymmetries and the Essence of Political Psychology. Political Psychology, 38: 167-208. https://doi.org/10.1111/pops.12407

Jost, J.T., Amodio, D.M. (2012). Political ideology as motivated social cognition: Behavioral and neuroscientific evidence. Motiv Emot 36, 55–64. https://doi.org/10.1007/s11031-011-9260-7

Jost, J. T., Nosek, B. A., & Gosling, S. D. (2008). Ideology: Its Resurgence in Social, Personality, and Political Psychology. Perspectives on Psychological Science, 3(2), 126-136. https://doi.org/10.1111/j.1745-6916.2008.00070.x

Kossowska, M., Szwed, P. & Czarnek, G. The Role of Political Ideology and Open-Minded Thinking Style in the (in)Accuracy of Factual Beliefs. Polit Behav 45, 1837–1857 (2023). https://doi.org/10.1007/s11109-022-09789-z

Krouwel, A., Kutiyski, Y., van Prooijen, J.-W., Martinsson, J., & Markstedt, E. (2017). Does Extreme Political Ideology Predict Conspiracy Beliefs, Economic Evaluations and Political Trust? Evidence From Sweden. Journal of Social and Political Psychology, 5(2), 435-462. https://doi.org/10.5964/jspp.v5i2.745

McClosky H, Chong D. Similarities and Differences Between Left-Wing and Right-Wing Radicals. British Journal of Political Science. 1985;15(3):329-363. doi:10.1017/S0007123400004221

Osborne D, Costello TH, Duckitt J, Sibley CG. The psychological causes and societal consequences of authoritarianism. Nat Rev Psychol. 2023;2(4):220-232. doi: 10.1038/s44159-023-00161-4.

Proch, J., Elad-Strenger, J. and Kessler, T. (2019), Liberalism and Conservatism, for a Change! Rethinking the Association Between Political Orientation and Relation to Societal Change. Political Psychology, 40: 877-903. https://doi.org/10.1111/pops.12559

Van Hiel, A., Onraet, E., Crowson, H. M., & Roets, A. (2016). The Relationship between Right–wing Attitudes and Cognitive Style: A Comparison of Self–report and Behavioural Measures of Rigidity and Intolerance of Ambiguity. European Journal of Personality, 30(6), 523-531. https://doi.org/10.1002/per.2082

Van Hiel, A., Onraet, E. and De Pauw, S. (2010), The Relationship Between Social-Cultural Attitudes and Behavioral Measures of Cognitive Style: A Meta-Analytic Integration of Studies. Journal of Personality, 78: 1765-1800. https://doi.org/10.1111/j.1467-6494.2010.00669.x

van Prooijen, J.-W., & Krouwel, A. P. M. (2017). Extreme Political Beliefs Predict Dogmatic Intolerance. Social Psychological and Personality Science, 8(3), 292-300. https://doi.org/10.1177/1948550616671403

Zmigrod L, Eisenberg IW, Bissett PG, Robbins TW, Poldrack RA. 2021 The cognitive and perceptual correlates of ideological attitudes: a data-driven approach. Phil. Trans. R. Soc. B 376: 20200424. https://doi.org/10.1098/rstb.2020.0424

Zmigrod, L. (2020). The role of cognitive rigidity in political ideologies: Theory, evidence, and future directions. Current Opinion in Behavioral Sciences, 34, 34–39. https://doi.org/10.1016/j.cobeha.2019.10.016

Zmigrod, L. (2022). A Psychology of Ideology: Unpacking the Psychological Structure of Ideological Thinking. Perspectives on Psychological Science, 17(4), 1072-1092. https://doi.org/10.1177/17456916211044140

Je fais mienne la conclusion d’un récent chapitre de revue de littérature de 2023 aux Oxford University Press (que Tranxen ne connaît certainement pas, vu qu’il ne le cite pas, malgré sa récence et le fait qu’il s’agit d’une synthèse au cœur du débat) :

Stern, C., & Ruisch, B. C. (2023). New Evidence on an Enduring Question: The Role of Political Ideology and Extremism in Dogmatic Thinking. In: V. Ottati & C. Stern (Eds.), Divided, Oxford University Press.

Abstract

For nearly a century, researchers have debated how people across the political spectrum differ in their psychological profiles. One particularly enduring question concerns the degree to which political conservatives (i.e., those on the right) and liberals (i.e., those on the left) differ in their degree of dogmatism. The authors review emerging evidence concerning ideological differences in dogmatic thinking, particularly cognitive rigidity and judgment (over)confidence. Partially confirming classic perspectives, they find that those on the political right (vs. left) exhibit more dogmatic thinking across many domains. Importantly, however, they identify certain circumstances under which the extremity of a person’s ideology (i.e., how strongly liberal or conservative they are) might be an equally (or perhaps even more) potent predictor of dogmatism. Lastly, they consider directions for future research that may hold promise of shedding further light on the nature of the relation between political beliefs and dogmatism.

Tranxen affirme ensuite que :

« Cette méta-analyse donc, elle s’appelle « Le conservatisme politique, une cognition sociale motivée ». Dès le titre et le résumé, on a une idée qui est quasiment absente de la conférence de PWE, celle de l’asymétrie idéologique. Cette méta-analyse supporte l’idée que les idéologies conservatrices sont adoptées en partie car elles vont satisfaire des besoins psychologiques particuliers (par exemple le besoin de contrôle)[9]. Et pour ça on va avoir différentes manières de tester le dogmatisme, mais aussi l’autoritarisme, les besoins existentiels, la rigidité, etc. Et selon les méthodes employés, certaines études attestent l’hypothèse (a) et invalident la (b)[10]. La présentation des résultats faite par Jost est donc beaucoup moins nette que ce que laisse penser PWE : l’hypothèse du « dogmatisme de droite » est loin d’être négligeable. »

Je n’ai effectivement pas abordé ce point, puisque je m’en suis tenu à une synthèse des nombreuses études ci-dessus (et je n’avais ni le temps ni la nécessité d’aller plus loin), mais Tranxen essaie d’échapper à cette importante partie des études qui indique un dogmatisme aux deux extrêmes, en invoquant l’asymétrie idéologique. Mais Tranxen ne connait pas les autres travaux qui montrent qu’il y a aussi des menaces plus fortes du côté gauche, et que donc l’asymétrie idéologique peut s’inverser si l’on tient compte des menaces « de gauche » (p.ex. liées à l’économie), comme le soulignent :

Brandt, M. J., Turner-Zwinkels, F. M., Karapirinler, B., Van Leeuwen, F., Bender, M., van Osch, Y., & Adams, B. (2021). The Association Between Threat and Politics Depends on the Type of Threat, the Political Domain, and the Country. Personality and Social Psychology Bulletin, 47(2), 324-343. https://doi.org/10.1177/0146167220946187

Bref, Tranxen n’est pas suffisamment armé pour critiquer mon point de vue autrement que de façon très superficielle, et donc finalement fausse.

Je présente l’étude de Imhoff et al. (2022) correctement comme une « méta-analyse » de 39 échantillons dans 26 pays et plus de 100’000 personnes à laquelle j’ai participé avec de nombreux collègues, pour la simple raison que les analyses sont de type méta-analyse (random-effect meta-analytic models), et le résultat est présenté comme un « forest plot », typique des méta-analyses. Cette étude 1 suggère le U qui penche à droite (l’hypothèse c additive) sur l’ensemble des pays, à la fois une tendance à plus de complotisme à droite qu’à gauche (relation linéaire) et à la fois une tendance à plus de complotisme aux extrêmes qu’au centre (relation curvilinéaire). L’étude 2 menée dans 23 pays regroupait près de 38’000 personnes, et ne montre que la relation curvilinéaire.

Notons ici l’interprétation des autrices et auteurs, très intéressante pour notre discussion, et que l’on peut considérer comme l’expression du consensus scientifique européen sur la question (presque tou·tes les spécialistes y sont ; j’ai enlevé les références citées dans ce paragraphe que vous pourrez retrouver dans l’article) :

« One way to make sense of such a U-shaped relation between political orientation and conspiracy mentality is grounded in the content-based overlap between conspiracy beliefs and worldview explanations on the political extremes. This worldview explanation is based on the notion that extreme political movements at both the left and right share a common set of features, which include a pronounced tendency to distrust and reject groups and ideas that differ from their own. The left and right extremes share a worldview that centres on Manichaean demonization of ideological outgroups, which are represented not only as wrong but as immoral and dangerous. Conspiracy theories similarly represent outgroups as evil, and are associated with Manichaean views of history as a struggle between good and evil forces vying for control of societies. Research on authoritarianism, a key antecedent of conspiracy beliefs, sometimes points to an authoritarianism symmetry hypothesis: authoritarian views in which dissent is not tolerated are observed on both the right- and left-wing extremes. Likewise, both extreme positions show an affinity to a belief in simple solutions, which is also associated with conspiracy beliefs. This worldview explanation thus suggests that the curvilinear relation in which conspiracy mentality is associated with extreme (left or right) political ideology is more or less universal across national contexts. Indeed, across time and cultures, conspiracy theories are common in the discourse of extremist fringe groups independent of ideology (extreme left, extreme right, religious fundamentalism and anti-technology) ».

La suite de la critique de Tranxen devient lunaire. Il affirme :